La evaluación de los programas sociales del gobierno federal —a fin de evitar la incorrecta asignación de recursos públicos— tiene que fortalecerse. Solo así podemos contar con información suficiente para determinar cuáles proyectos deben continuar, cuáles transformarse y cuáles desaparecer debido a su regresividad.

¿A qué conclusión llegamos cuando observamos que dentro de los beneficiarios del Programa de Apoyos Directos al Campo (Procampo) hay más de 500 mil registros repetidos en una sola entidad federativa?,1 ¿o cuando indagamos qué pasa con la educación en las comunidades indígenas, y parte de la respuesta es que los asesores comunitarios no cumplen con su labor por atender “gestiones con el sindicato”?2 Estos datos son evidencia dispersa de lo que ocurre con algunos grupos de interés en torno a los programas sociales en nuestro país. Podemos inferir que detrás de cada beneficio existen grupos sociales que se movilizan y que durante años se han ganado el derecho a los recursos públicos.

La contraposición de intereses no es realmente grave, pues la construcción de lo público requiere necesariamente de la defensa de diferentes causas y por lo tanto de diferentes grupos que negocian qué valores deben permanecer por encima de otros.3 Lo grave es que en un contexto de desigualdad como el mexicano se permita la protección de ciertos sectores que lejos de necesitar mejores condiciones sociales resultan beneficiados para mantener un sistema de poder vertical y clientelista.

¿Cómo romper la inercia de la asignación de recursos públicos basada en una lógica de poder? Una respuesta posible es apostar por la evaluación. Hace apenas algunos años no teníamos acceso a los registros de quienes se beneficiaban con los esquemas de subsidios gubernamentales, ni mucho menos de cómo eran los procesos administrativos que se encadenaban para la provisión de recursos a cargo del gobierno. Hoy contamos con más información al respecto, gracias en parte a la evaluación de los programas gubernamentales.

Este artículo presenta tres argumentos sobre cómo las evaluaciones han generado información valiosa, revelando la manera en que se ha estructurado la distribución de los recursos de los programas sociales en México. El reto consiste en usar esta evidencia para lograr condiciones sociales más equitativas.

Delimitar el margen de acción

A raíz de las Evaluaciones de Diseño y de las Evaluaciones Específicas de Desempeño (EED) coordinadas por el Coneval, se ha hecho un esfuerzo sistemático para que los operadores de los programas definan claramente quiénes son sus beneficiarios. ¿A quiénes llegan los libros del Programa Nacional de Lectura? ¿En qué proporción se ha ampliado la cobertura del Seguro Popular? ¿Qué regiones del país se incluyen en la estrategia de Zonas Prioritarias?

La definición de población potencial —es decir aquellos que dentro del universo de ciudadanos y por sus condiciones particulares son susceptibles de obtener beneficios— y la diferencia entre esta y la población objetivo —la que representa la meta planteada por el programa— han sido fundamentales. En esa lógica, no debemos olvidar el significado de población atendida, es decir aquella a la que el programa realmente lleva los instrumentos de política pública: leche, libros, subsidios, transferencias condicionadas, entre otros. Por increíble que parezca, muchas iniciativas gubernamentales no tenían claramente determinado su margen de acción.4 Cuando existe ambigüedad en estas definiciones se corre el riesgo de llegar a situaciones tan absurdas como dar fórmulas nutrimentales a niños que no están en condición de desnutrición, premiar con becas a estudiantes que no han comprobado mérito ni necesidad justificada para obtenerlas, entre otras inconsistencias.

En el caso de Procampo, la falta de un sistema de medición de la gestión operativa obstaculizó el contar con datos fidedignos para confirmar que los beneficiarios inscritos en el padrón realmente representaban la población objetivo del programa. En efecto, la depuración del padrón ha sido una demanda constante por parte de los productores agrícolas, ya que se ha identificado en el transcurso de los años una gran cantidad de duplicidades y anomalías.

Una receta para varios males

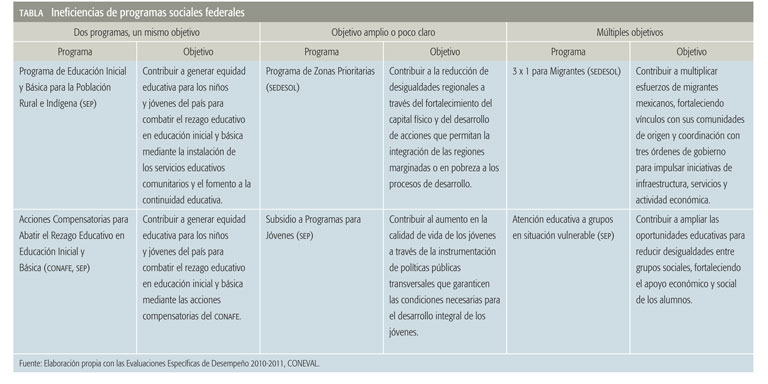

La persecución de varios fines a la vez es un problema común de las políticas públicas en México y los programas sociales no escapan a esta condición. Si nos remitimos a sus propias reglas de operación podemos ver que: (1) varios programas atienden el mismo problema y no necesariamente hay una coherencia entre las diversas acciones que los componen, (2) otros programas no tienen claro el objetivo que deben cumplir y (3) en otros casos un solo instrumento persigue múltiples objetivos. Podemos ver un ejemplo en la Tabla.

Si evaluamos los programas según la concordancia entre el propósito planteado y las actividades que llevarán a dicho objetivo, es probable que en la mayoría de los casos no se cumpla la concordancia. Las razones para tal incongruencia probablemente tengan que ver con la vaguedad de los fines y con la ausencia de una lógica causal clara. Las evaluaciones también son un instrumento clave para acotar el propósito de los programas.

Evaluar el impacto

Las evaluaciones de los programas federales no han sido precisas en todos los casos. No obstante, los casos de éxito de las evaluaciones de impacto no deben desestimarse.5 Hoy sabemos que gracias al Programa de Desarrollo Humano Oportunidades, y a casi 15 años de su intervención, hay un impacto positivo en el nivel educativo nacional —en especial en la población indígena— así como una mejora en matemáticas en los niños que estaban en primaria al inicio del programa. Otros resultados revelan que hay una tasa de incremento salarial en los jóvenes beneficiarios —entre 12 y 14%— y un aumento en la estatura de los niños favorecidos con las iniciativas nutricionales contempladas en el proyecto.6

Si recurrimos de nuevo al procampo, vemos que los resultados de varias evaluaciones ponen de manifiesto la manera en que dicho programa ha agudizado las brechas en la desigualdad. La mitad de los beneficiarios del programa tiene menos de dos hectáreas, pero solo reciben 13% de las transferencias; mientras que 3.8% de los productores con predios mayores a 18 hectáreas obtienen una tercera parte del total de ellas. Es decir, el decil de productores más ricos concentra casi 42% de las transferencias, mientras que el decil más pobre de productores percibe apenas 2.2% de los beneficios del programa.7

Frente a estos datos, es difícil permanecer pasivos. Las evaluaciones que se han generado en los últimos años revelan quiénes son los beneficiarios, cuáles son los propósitos de los programas y cómo han cambiado las condiciones socioeconómicas a partir de su instrumentación. A estas alturas, hay suficiente evidencia del impacto de los programas, los que sirven y los que hay que suplir; la tarea para los próximos años es utilizar estos resultados para romper el status quo y las estructuras tradicionales de poder.

1 Este dato corresponde a los registros de apoyos en Sinaloa entre 1994-2010. El cálculo se hizo con base en el padrón oficial del programa, en colaboración con Marco Jair Quintana. Padrón disponible en .

2 Evaluación Específica de Desempeño 2010 y otras evaluaciones al programa Asesor Técnico Pedagógico de la SEP.

3 Mark H. Moore, Creating Public Value: Strategic Management in Government, Harvard University Press, Boston, 1995.

4 Parte de este problema se ha corregido con la matriz de indicadores de resultados (MIR) y la matriz de marco lógico que los operadores de los programas sociales deben definir y que sirve como insumo de varias evaluaciones. Para conocer más al respecto remítase al sitio del coneval: .

5 Una práctica generalizada es inferir los resultados de impacto a partir de resultados operativos o de percepción de los beneficiarios, sin cruzar los resultados con otras estadísticas. Muchas evaluaciones se apropian del adjetivo “de impacto” cuando en realidad carecen de una metodología experimental o cuasiexperimental que permita realmente contrastar las condiciones previas de los beneficiarios y los resultados posteriores a la intervención de los programas.

6 Evaluación Externa del Programa Oportunidades: A diez años de intervención en zonas rurales (1997-2007), INSP y CIESAS y EED 2010-2011, CONEVAL, 2008.

7 J. Scott, “Subsidios Agrícolas en México: ¿Quién gana, y cuánto?” en Subsidios para la desigualdad: Las políticas públicas del maíz en México a partir del libre comercio, Jonathan Fox y Libby Haight (coord.), Woodrow Wilson International Center for Scholars, UC Santa Cruz/CIDE, 2010.

______________________________________

MARÍA JOSÉ MONTIEL es colaboradora externa del Instituto Mexicano para la Competitividad, AC (IMCO).